令和7年度は「AIと広告」をテーマに法政委員会勉強会を開催します。

前回の勉強会では、AIの技術的な進化状況や便利な活用方法など、AIのプラス面に焦点を当てていましたが、第二回となる今回はAIのリスク面を取り上げます。

AIは有用なものですが、「データが公平性に欠ける場合がある」「AIが誤った情報を生成してしまう」「AIの判断過程がブラックボックスである」といったリスクもあります。特に生成AIをベースにして新しく登場してきた推論系AIは、人間の命令を曲解するということも分かってきました。

AIのリスクに対処するために各国が規制を進める中で、トランプ政権によるAI推進の方向性もあり2025年はAIの規制やリスクコントロールに関する風潮が変わりつつある年となっています。

AI規制に関する最新動向はどのようなものなのでしょうか。

2024年までの各国の動き

まずは、2024年までのAI規制の状況を振り返ります。

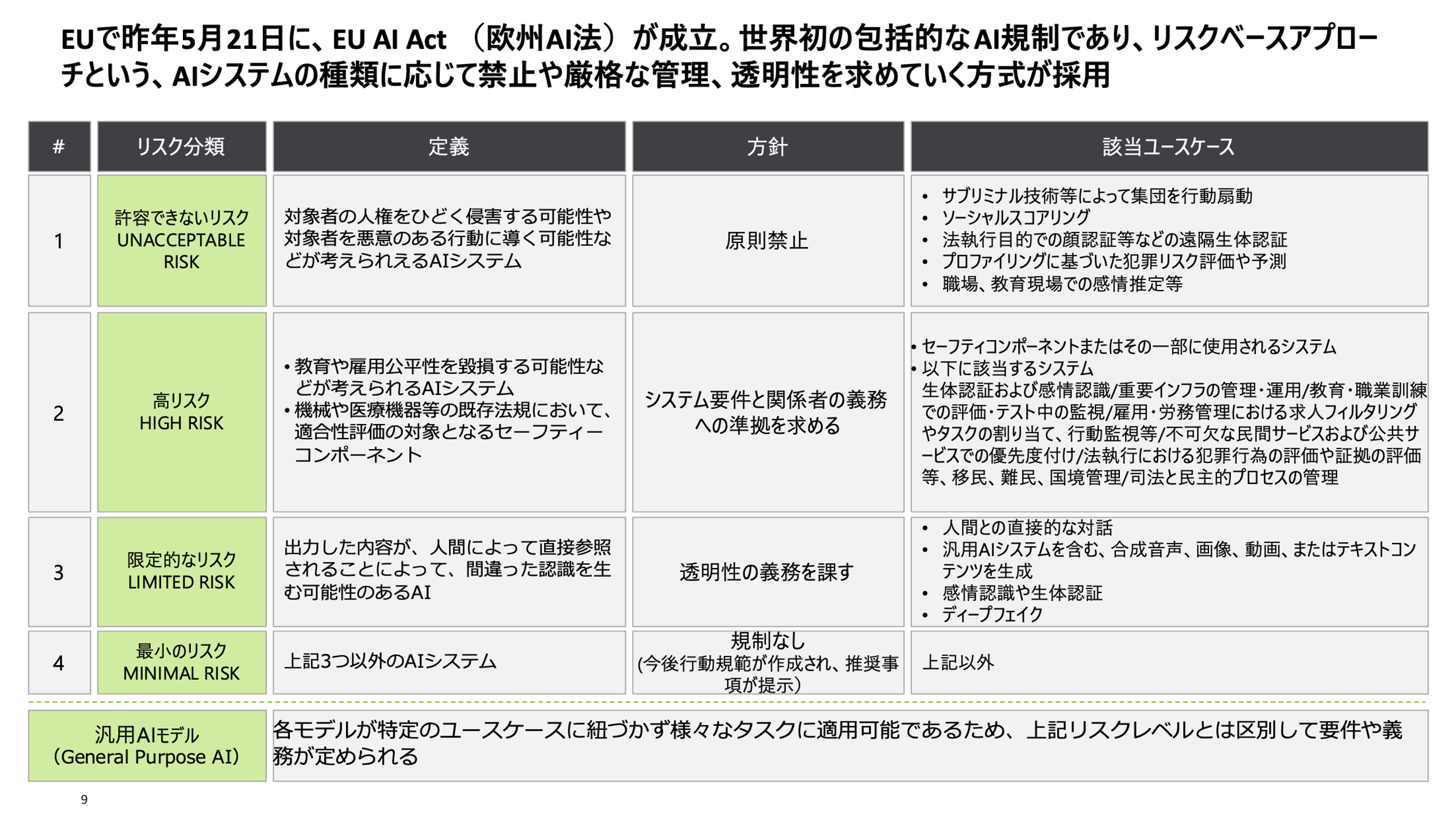

EUでは、2024年5月に世界初の包括的なAI規制として「EU AI Act」が承認されました。同規制では、AIのユースケースに基づいてリスクを分類し、禁止や管理の対象や違反時の罰金が設定されています。

具体的には、AIのユースケースにより「許容できないリスク」「高いリスク」「限定的なリスク」「最小のリスク」といった4種類に分類されます。「許容できないリスク」では、たとえば職場や教育現場での感情推定が禁止され、AIによる心理面にも踏み込んだ健康チェックや感情に基づくアドバイザリといった活用方法は禁止されます。

気を付けなければならないのが、この規制はAIの提供者だけでなく、利用者も対象となるという点です。たとえばウェルビーイングのためにAIを使っている日本企業においては、EUに在住する社員を対象とした場合、高額の罰金が適用される可能性があります。

日本においては、2023年のG7にて「広島AIプロセス」をリードし、生成AIに関する国際的なルールの検討を開始しました。またこの流れで日本においてもAISI(AI Safety Institute)と呼ばれるAIの安全性を確保するための公的機関が誕生し、海外機関との連携も開始しています。

また、2024年7月には、経済産業省より「コンテンツ制作のための生成AI利活用ガイドブック」が公表されました。

本ガイドブックは、コンテンツ制作者がAI技術をどのように活用できるか、またその際にどのような法的留意点があるのかについて解説されています。

また、具体的な活用ケースとして「ゲーム産業」「アニメ産業」「広告産業」など業界別に活用事例や留意点、対応策まで解説されており、非常に有用です。

2025年、AI規制の風向きに変化

このような中、前述のとおり2025年ではAI規制の議論や動向に変化が見られます。

まず国内では、2月28日に政府が「人工知能関連技術の研究開発及び活用の推進に関する法律(AI法案)」について閣議決定を行いました。本法律はAIのリスクコントロールを行うものでもありますが、EU AI規制法と異なり罰金や罰則もなく、AIの推進を後押ししていく面もあるものとなっています。

また、経済産業省の産業構造審議会 知的財産分科会でも、AIと知財制度に関する様々な議論が進んでいます。たとえば、これからの創作活動に関して生成AIの利用は必須であるという認識のもと、生成AIを使った制作物について著作権や意匠権を認めるべきかといった議論が行われています。

さらに、個人情報保護法の見直しも進んでいます。現在の個人情報保護法では、個人から同意を得る原則をもっていますが、実態や世界的な潮流にあわせて個人情報の取り扱いについてドメインやユースケースに合わせて変えていく議論が進んでいます。

各国でも、「ソブリンAI(AI主権)」の確立とも推察される、AI推進の動きが加速しています。アメリカでは2023年10月にバイデン政権によりAIの安全性に関する新基準を大統領令として公表しましたが、これはトランプ政権になり撤回され、規制よりも技術推進が優先される方向へと大きく舵が切られました。

また、AI技術に関する中国の影響力も無視できません。現在、中国ではAIを国家戦略の中核と捉え、国家管理の確立に向けてAIの標準整備が進んでいます。これは、AIを単なるツールではなく、安全保障や経済競争力の柱として位置づけ、国家主導でガバナンスと統制を進めていくという姿勢を意味しています。

EUにおいては、GDPR(General Data Protection Regulation:EU一般データ保護規則)やEU AI Actに代表される規制主導型の流れについて、今後は見直しが必要ではないかという議論が始まっています。

今年の2月にパリで開催されたAIアクションサミットでは、フランスのマクロン大統領がAIデータセンターに17兆円を投資することを発表するなど、AIに対してアクセルを踏む発表もされました。またイギリスでは、AI開発競争が進む中で国家安全保障の観点でAIを重要視する方針を明らかにし、AISIの名称をAI Safety Institute から、AI Security Institute (安全保障)と名称を変更しています。

ここまでご紹介した通り、2024年まではEU AI Actが注目され、世界的にAIの規制が進むと思われていましたが、2025年に入り国際的なスタンスは大きく変化し、AIを管理から活用・推進へと捉えられる動きが強まっています。

AIの信頼性向上のために求められるガバナンス

このような流れもありつつも、もちろんAIの活用においてはリスクを踏まえた信頼性向上のための取り組みが必要です。

博報堂DYグループでは、AIの活用はもちろん、AIのリスクについても考慮し、生活者と社会に資する人間中心のAIを実現するためにHuman-Centered AI Institute(HCAI)を立ち上げています。

AIが人の創造性を高め、社会的な価値を提供していくためには、AIの信頼性を高めなければなりません。HCAIでは、信頼できるAIの基盤を作るために、昨年にAIポリシーを定め、公表しています。

博報堂DYグループのAIポリシー策定について ~生活者を中心にしたAIの未来に向けて~

AIポリシーでは、従来のAIの原則を守りつつも、生成AI時代のリスクも反映し、生活者をどう守るかを踏まえた内容となっています。

本ポリシーに合わせて博報堂DYグループでは全社横断のAIガバナンス体制を構築しており、グループの主要会社を横断した総務・法務・広報・情報システム・リスクコントロール、そしてプラットフォーム開発を行う統合組織を立ち上げました。

特に広告やクリエイティブの業界においては、著作権の問題は非常に大きいものです。AIが著作権のあるデータや他社のデータに基づきアウトプットしているのではないかという疑義や、AIのアウトプット自体が他社の権利を侵害しているのではないかという懸念もあります。

このような背景もあり、当社ではAIのアウトプットが著作権に違反しているかどうかをチェックできるツールを開発し、自社内でのチェックプロセスの強化を進めています。単に似ている・似ていないというだけではなく、そのアウトプットが著作権に違反する意図があるのかといったことを確認できる内容となっています。

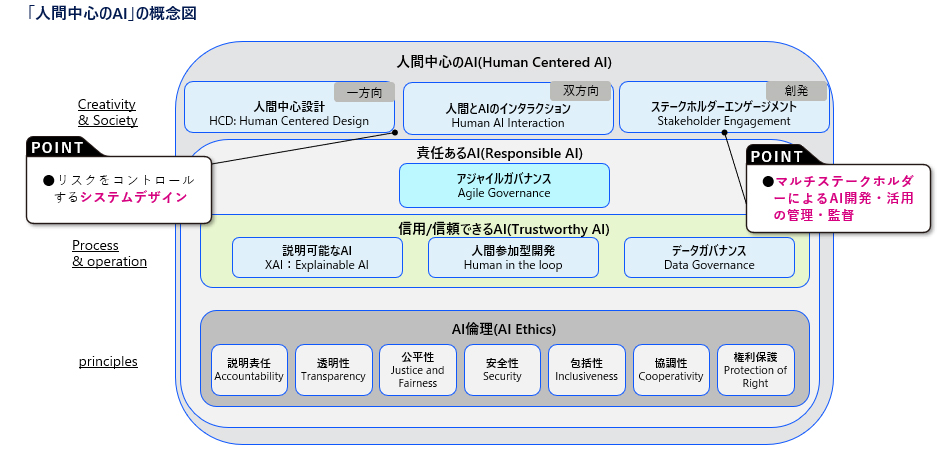

AIのガバナンスモデル自体も時代に合わせて見直していかなければなりません。これまで意識されてきたAIの「透明性」や「安全性」「公平性」などのいわゆるAI倫理を守ることはもちろん、信用・信頼できるAIを実現するために「説明可能であり」「利用するデータが適切に管理されている」ことも必要です。

そのうえで、ガバナンスの仕組み自体をアジャイル的に継続アップデートし続けることで、初めて責任あるAIが達成されます。

加えて、加速度的に普及するAIの社会的影響力を考慮し、AIの開発・活用・管理に、生活者を含む、幅広いマルチステークホルダーの参画が重要になります。

人間中心のAIを実現するためには、このようにAIガバナンスのアップデートも求められます。

今回は、AI規制の最新動向と信頼性向上のために必要となるガバナンスについて学びました。 AIは便利なものではありますが、一方で権利侵害や悪意を持った利用などのリスクも考慮しなければなりません。AIを適切に利用していくためには、AIの進化に合わせたガバナンスが求められるといえるでしょう。

第2回 AI規制の動向および、

第2回 AI規制の動向および、